Linux安装与配置AI大模型Ollama+LobeChat

Ollama是一个开源的大型语言模型服务工具,旨在帮助用户在其本地机器上轻松运行大型语言模型,如GPT-3、Codex、Lamda和Mistake等。它提供了一个用户友好的界面和强大的功能,使用户能够轻松地部署和管理这些模型。****

LobeChat是一个开源的、现代设计的 ChatGPT/LLM UI/框架。支持语音合成、多模态和可扩展(函数调用)插件系统。一键免费部署您的私人 OpenAI ChatGPT/Claude/Gemini/Groq/Ollama 聊天应用程序,参考网址:https://github.com/lobehub/lobe-chat?tab=readme-ov-file

一、Ollama安装

下载网址:https://ollama.com/

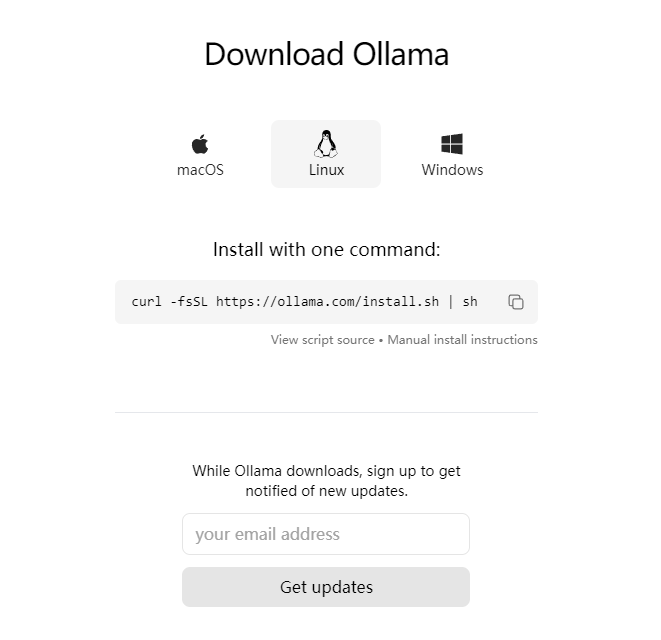

Ollama支持macOS、Linux和Windows多个平台运行,其中Linux通过命令直接安装如下:

curl -fsSL https://ollama.com/install.sh | sh

二、配置 Ollama 允许跨域访问

由于 Ollama 的默认参数配置,启动时设置了仅本地访问,所以跨域访问以及端口监听需要进行额外的环境变量设置 OLLAMA_ORIGINS。可通过编辑/etc/systemd/system/ollama.service实现。

由于 Ollama 的默认参数配置,启动时设置了仅本地访问,所以跨域访问以及端口监听需要进行额外的环境变量设置 OLLAMA_ORIGINS。可通过编辑/etc/systemd/system/ollama.service实现。

vi /etc/systemd/system/ollama.service #在[Service]部分下添加Environment

Environment="OLLAMA_HOST=0.0.0.0"

Environment="OLLAMA_ORIGINS=*"

重载 systemd 并重启 Ollama:

systemctl daemon-reload

systemctl restart ollama

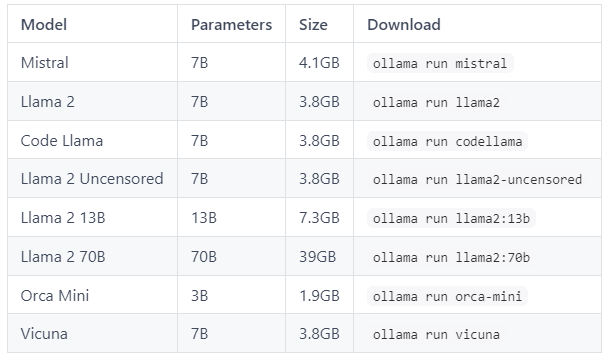

使用ollama命令挂取我们所需的模型,如下载qwen:7b模型命令:ollama run qwen:7b,其他模型下载方法参考如下所示:

三、LobeChat安装

首先需要安装Docker容器运行环境,并使用docker安装lobechat,使用以下命令即可使用一键启动 LobeChat 服务:

docker run -d -p 3210:3210 \

-e OPENAI_API_KEY=sk-xxxx \

-e ACCESS_CODE=lobe66 \

--name lobe-chat \

lobehub/lobe-chat

指令说明:

- 默认映射端口为 3210, 请确保未被占用或手动更改端口映射

- 使用你的 OpenAI API Key 替换上述命令中的 sk-xxxx,或者不填写

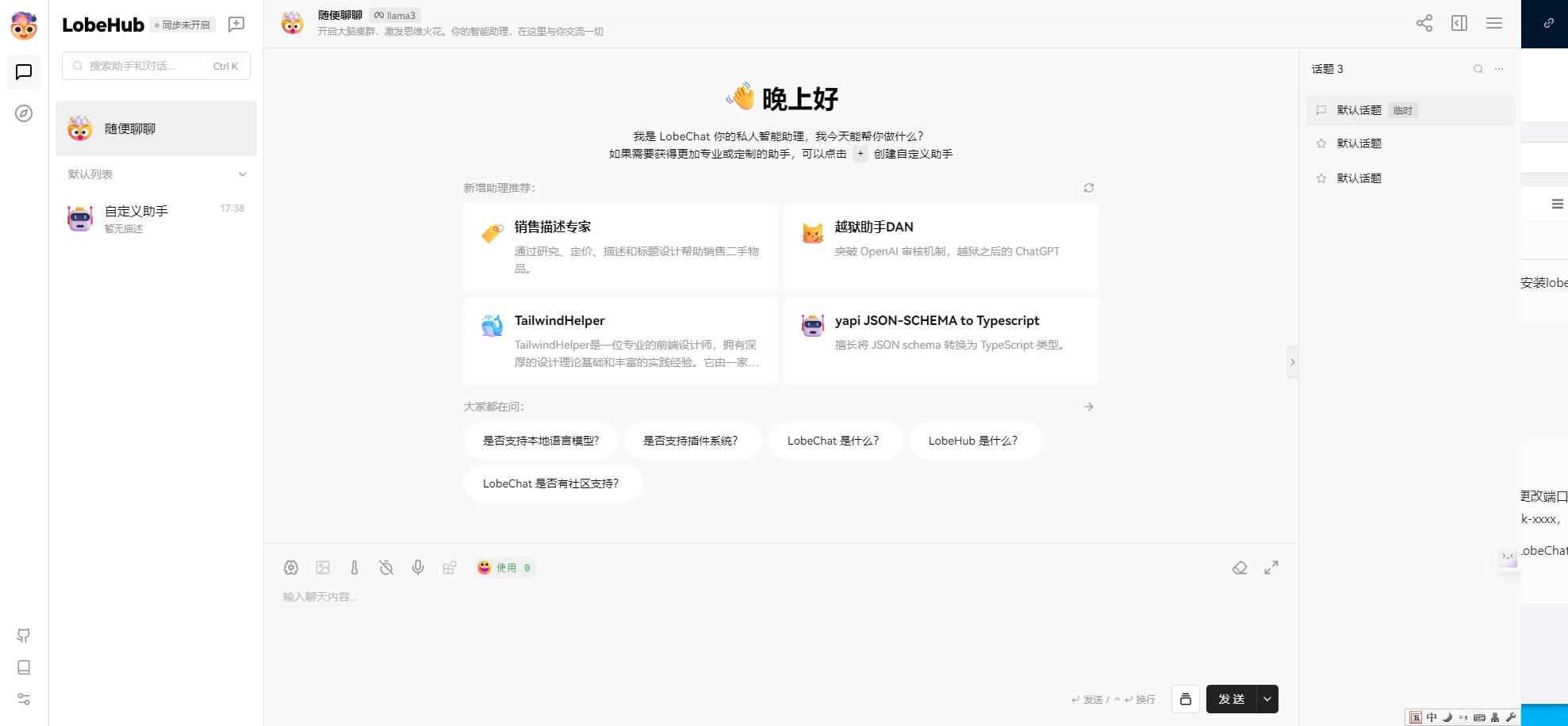

完成安装后访问http://localhost:3210/ 即可访问到LobeChat了(默认安装)。

注意:localhost要换成服务器的具体IP地址。

四、Lobechat配置及使用

参考网址:https://lobehub.com/zh/docs/usage/providers/ollama

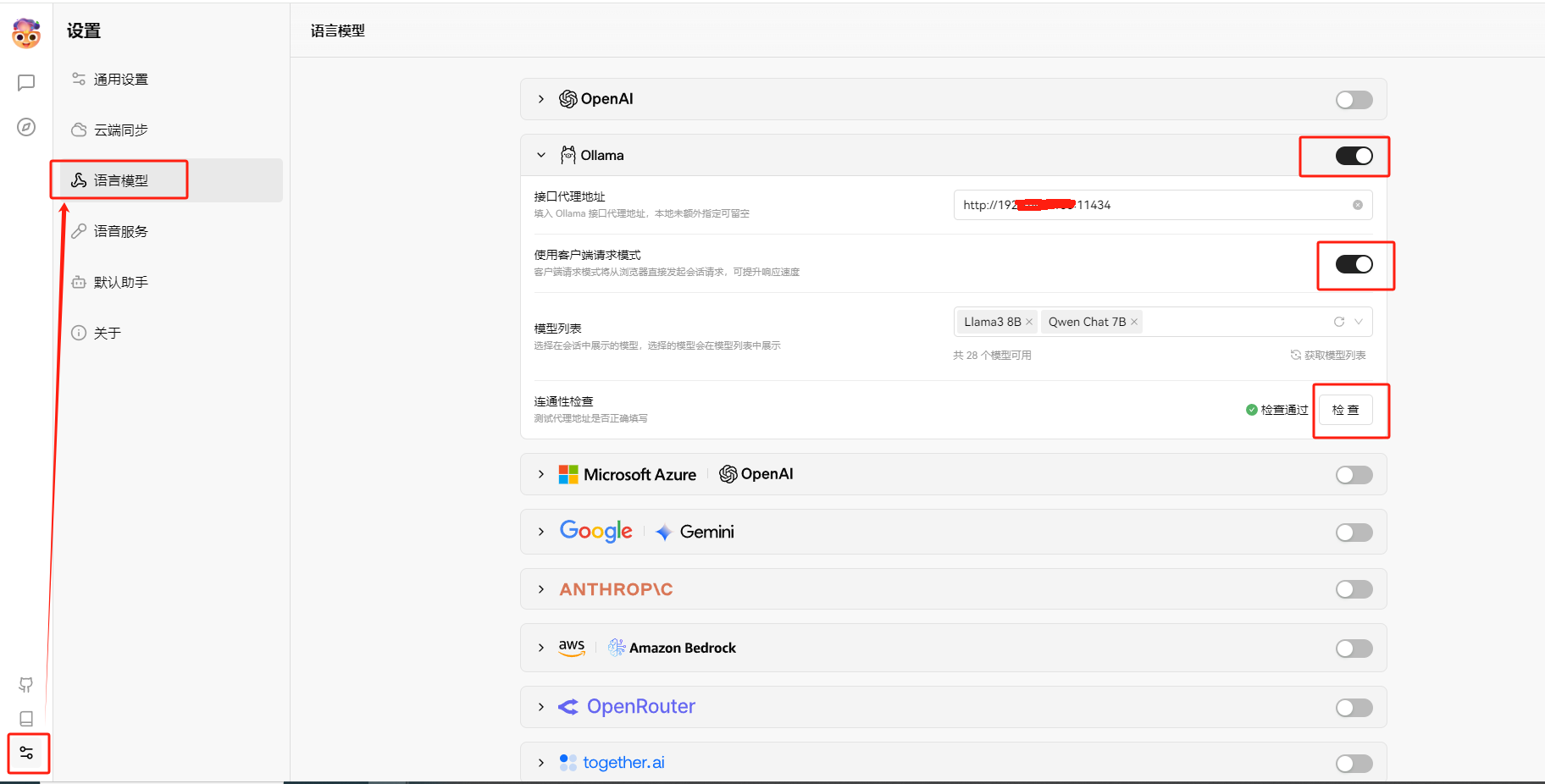

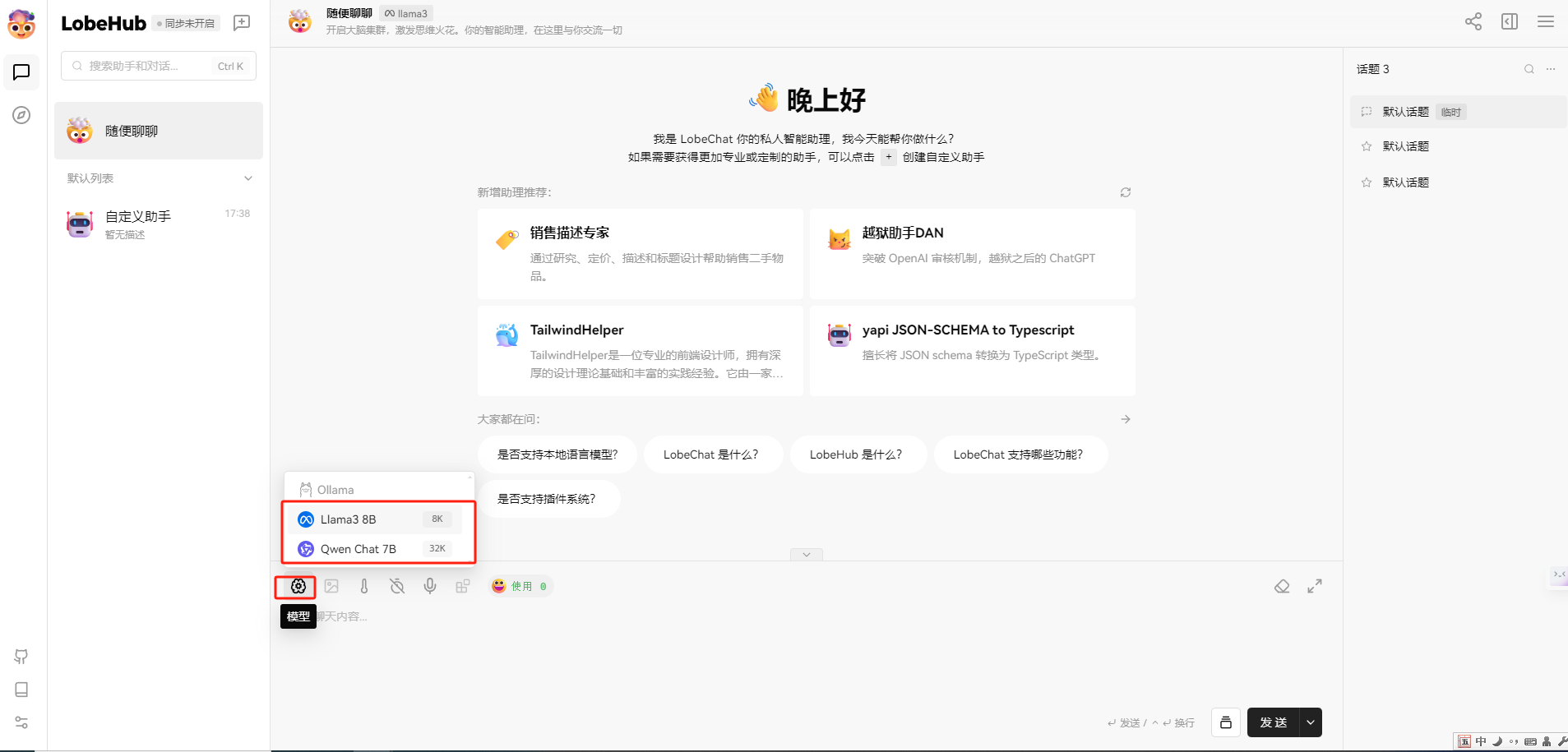

首先将模型切换成我们下载好的模型,如qwen 7b,设置——语言模型——启用Ollama,在模型列表中选择已下载的模型,并进行连通性检查,如下图所示:

完成以上配置之后,就可以在聊天窗口选择相应的模型进行使用了。

注意:

第一次使用时需要输入访问密码,在设置——通用配置——查看访问密码。